|

|

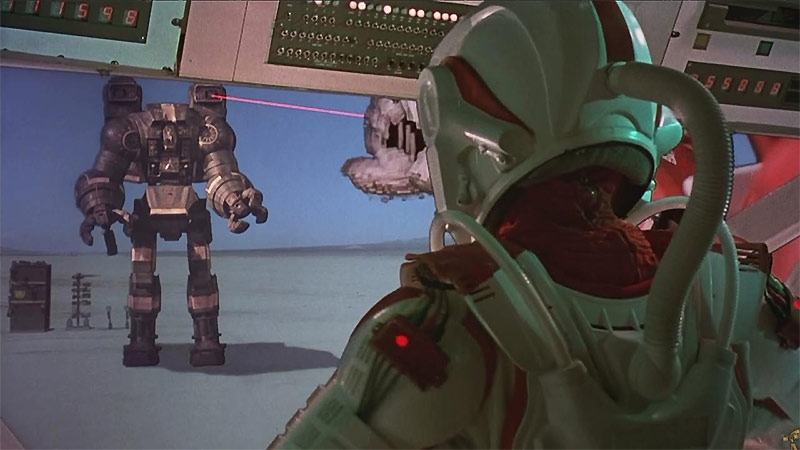

Георгий Почепцов. Боевые роботы наступают: автономия как военно-стратегический концептМир начал стремительное развитие не только к новому миропорядку, но и к новым технологиям, которые будут создавать этот миропорядок. Среди этих технологических прорывов стоит и развитие искусственного интеллекта. В 1993 г. Вернор Виндж первым заявил об идее технологической сингулярности как о создании вне человека суперчеловеческого разума ([1], см. также [2-3]). Он увидел это будущее через 30 лет, считая, что после этого время людей закончится. При этом он считал, что биологическая наука также может усилить человеческий интеллект, тем самым отодвинув это будущее.  Известный футуролог Рєймонд Курцвейл уже сегодня предсказывает, что искусственный интеллект сравняется с человеческим уже через 12 лет [4]. Все это ведет к новым изменениям социального порядка. Так, в соответствии с исследованиями Кембриджского университет 47% профессий США будут автоматизированы в следующие двадцать лет, включая не только рабочие, но и офисные профессии [5]. Однако одновременно происходит падение уровня IQ в мире [6]. Проводятся конференции, призванные очертить возможные виды взаимодействия человека с искусственным интеллектом [7]. Главной проблемой при этом становится этическая. Бывший советник Обамы по проблемам сферы здоровья Э. Эмануэль считает, что потеря работы для человека будет иметь нехорошие последствия , поскольку осмысленная работа является важным элементом нашей идентичности [8]. Известный философ Дэниел Деннет акцентирует принципиальную возможность построения искусственного интеллекта: «Я говорил все время, что в принципе человеческое сознание может быть реализовано в машине. Если разобраться, то мы сами такие. Мы роботы, сделанные из роботом, сделанных из роботов. Мы ужасно сложные, триллионы движущихся частей. Но все они являются не-чудодейственной роботизированными частями» [9]. Автор книг на тему использования искусственного интеллекта, нанотехнологий в военном деле Л. Дел Монт говорит: «Сегодня нет законодательных ограничений по поводу того, как много разума может иметь машина, как взаимосвязано это может быть. Если так будет продолжаться, посмотрите на экспоненциальный рост. Мы достигнем сингулярности в то время, которое предсказывает большинство экспертов. С этого времени главными видами больше не будут люди, это будут машины» [10]. Дел Монт видит опасность в развитии искусственного интеллекта в создании автономного оружия в том, что другие страны тоже создадут такое же оружие в ответ только без мирного протокола [11]. Ядерное оружие было создано, и только одна сторона с тех пор его применила. Теперь все воздерживаются от его использования из-за боязни взаимоуничтожения. Кстати, Россия также активно смотрит в сторону войн будущего [12-13]. Если мы посмотрим на интервью ведущих представителей американской военной элиты, то они как раз изучают этот новый концепт — автономию, с которым связывают серьезное будущее. Последствия его внедрения ставят в один ряд с появлением ядерного оружия. Предыдущий министр обороны Эштон Картер, который до этого поста занимался теоретической физикой, был профессором Гарварда, говорит о роли автономии: «Думаю, что это изменит ведение войны фундаментальным образом. Не уверен, что нечто, производимое автономно, сможет соперничать с разрушительной силой ядерного оружия. Я также считаю автономию сложным понятием. Не следует забывать, что когда мы сталкиваемся с использованием силы для защиты цивилизации, одним из наших принципов должно быть наличие человека для принятия критически важного решения» [14]. В принципе, если задуматься, это парадоксально, поскольку создается самое совершенное оружие, способное действовать вне человека, но, как оказывается, ему все равно нужен человек, поскольку без участия человека резко возрастает опасность непредсказуемых последствий. Глава научных исследований ВВС Г. Захариас, перечисляя автономию наряду с такими прорывными подходам и, как нанотехнологии, лазеры или гиперзвук, говорит: «Автономия не является конкретной системой вооружения, это предоставление новых возможностей. […] Автономия в движении — это то, что мы знаем в качестве нормально робототехники на земле или на море. Но в остальном автономия это помочь в принятии решений. Например, сейчас мы в ручную просматриваем видео в поисках плохих парней, но это, конечно, может делаться в автоматических системах слежения, которые развиваются. Идеей является подключение машин к проблемам big data» [15]. Как видим, речь идет о взаимодействии человека и машины. При этом зам.министра обороны Роберт Уорк акцентирует следующее: «Путь, по которому мы пойдем по развитию взаимодействия человек-машина, заключается в том, чтобы машина помогала людям принимать лучшие решения быстрее» [16-17]. По сути это отражено в анализе будущей войны 2050 г., который был сделан достаточно известными специалистами [18]. Кстати, тут есть и такие отдельные подразделы, как «Дезинформация как оружие», «Микротаргетинг», «Когнитивное моделирование оппонента», что вполне интересно и для мирных целей. Дезинформация, например, обсуждается в следующем разрезе. Раньше солдат получал информацию из достоверных источников. Сегодня, получая информацию из разных источников, солдату требуется оценивать качество этих информационных источников. Микротаргетинг в военном понимании это уничтожение, к примеру, не здания, а конкретного индивида. В качестве примера когнитивного моделирования военные отмечают сегодняшний нейромаркетинг, который позволяет четко ориентировать на конкретные потребности потребителя. Поскольку доминирующими все это время были технологии, связанные с информационным веком, то авторы считают, что следует думать в этом же направлении, анализируя будущую войну 2050 г. При этом сразу следует отметить появившуюся в ответ активность о запрете разработок такого оружия, которое будет действовать вне человека [19-20]. И это вполне понятно: то, что хотят военные, часто не совпадает с тем, что хочет общественность. Общественная кампания направлена на то, чтобы «остановить убийц-роботов». Масла в огонь тут могут подливать не столько секретные разработки военных, сколько вполне мирные статьи типа «Обсуждение автономии и ответственности военных роботов», которые, например, печатаются в журнале под характерным названием «Этика информационных технологий» [21]. Развитие технологий не может быть предсказано с большой определенностью, поэтому и возникают соответствующие опасения. При этом констатируется, что автономия не является хорошо понимаемым концептом. Поэтому и возникает опасение, что «никто из людей не будет нести ответственности за поведение (будущих) автономных роботов». То есть мы видим, что понятие автономии все время вращается вокруг проблемы принятия решений. А это в принципе (и без роботов) является на сегодня проблемой номер один во всех сферах: от бизнеса, когда решение принимает покупатель, и выборов, где решение принимает избиратель, до военного дела. Авторы статьи об ответственности роботов, подчеркивают, что технологии «позволяют людям делать то, что они не могли до этого, в результате чего они меняют роли и ответственности и создают новые. Такая же ситуация и с роботами. Отслеживая различные пути выполнения задач роботосистемами является базовым для понимания того, как задачи и ответственности создаются и распределяются по всей широкой социотехнической системе». Следует также вспомнить, что сетевая война, предложенная как концепт Дж. Аркиллой, по сути имела главной характеристикой неиерархический характер боевых единиц (повстанцев), которые могли сами принимать решения, в отличие от армии как иерархической структуры [22-24]. Армия сможет их побеждать, только если сама перейдет на сетевую форму существования, в противном случае она всегда будет запаздывать с принятием своих решений против сетевого противника, который делает это моментально. Первые разработки уже по собственно автономии в рамках министерства обороны появились в 2012 г. [25]. Тогда были поставлены ряд задач, среди которых были и такие:

В целом возникающие проблемы в военном деле, из-за которой «на службу» была призван автономия таковы:

В результате через несколько «итераций» дискуссий пришли к четкому пониманию понятия автономии. Это уже взгляд из 2016 г.: «Автономия является результатом передаче решения уполномоченному на принятие решений объекту в рамках конкретных ограничений. Важное различие состоит в том, что системы, управляемые предписывающими правилами, которые не разрешают отклонений, являясь автоматическими, не являются автономными. Чтобы быть автономной, система должна иметь способность сама независимо вырабатывать и выбирать среди разных возможных типов действий для достижения целей, опираясь на знание и понимание мира и ситуации» [26] Этим определением военные пытаются закрыться от множества пониманий и интерпретаций понятия автономии. Например, выделяют семь мифов автономии [27]:

В продолжении этой статьи прозвучали слова, которые можно трактовать как базовую точку отсчета: «Технология, которую часто называют как «автоматизация», а в более продвинутой форме «автономией, сделала современный труд более когнитивно сложным. Теория и исследования в сфере сложных систем демонстрируют широкий консенсус по поводу того, что существенная сложность не может быть уменьшена. Следует признать сложность (и увеличение сложности) стойким и растущим фактом. И иметь с ним дело. Будет опасной ошибкой пытаться избежать сложности с помощью редукционистских представлений и пытаться порождать простые решения» [28]. Из всего этого становится понятным, что не только взаимодействие с человеком является точкой отсчета, но и все возрастающая сложность технологий, которыми человек реально с помощью сегодняшнего уровня знаний не в состоянии справиться. Пока мы находимся на начальной стадии этих процессов. И это видно по ближайшим прогнозам, например, такому: «Если сегодня в США один пилот дистанционно управляет одним беспилотником, то вскоре один человек будет управлять несколькими» [29]. Сегодня уже каждый потребитель информации сталкивается с тем, что объемы информации привели к трансформации понятия правды, факта и под. Мы получили мир пост-правды, в котором разного рода фейки заняли неподобающее им место. Перед нами возникла та же ситуацию, что и при обсуждении военных проблем. Только у военных все это связано с применением оружия, что напрямую отсутствует в мирных ситуациях, хотя косвенно может вести и к такого рода последствиям. Из Автономии 2016 г. «вытягивается» такая идея: «Будет более важно постоянно обучать и тренировать людей-пользователей, чем развивать программное и аппаратное обеспечение для автономных систем. «Распространение таких систем уже представлено в частном секторе, где присутствует не так много умных противников, желающих изменить данные или победить противника» [30]. Поскольку на авансцену вышло понимание войны как справедливой, то убийство дроном гражданского человека является проблемой (31], см. также целую книгу на эту тему, где представлены этические, юридические и политические перспективы автономии [32]). При этом программное обеспечение робота все равно будет написано человеком. Как неоднократно подчеркивается, на человека все равно остается вся ответственность. Поэтому в таких текстах подлинная автономность прячется где-то далеко в будущем. Ср., например, следующее высказывание: «Автономные системы независимы настолько, насколько позволяют их программы, и все равно определение возможностей в данной ситуации лежит на людях-операторах. Поэтому пока органические основанные на ДНК компьютеры не сойдут со страниц комиксов на поле боя, люди-операторы останутся на контроле автономных приложений» [32]. Базовый текст 2016 г. подчеркивает необходимость доверия к системе. При чем подчеркивается, что в коммерческих вариантах нет таких тяжких последствий, которые возможны на поле боя. Отсюда следует невозможность переноса бизнес-практики в военное дело. В американском анализе будущей войны 2050 г. четко постулируется участие роботов в будущей войне. Там говорится следующее: «Роботы буду обычно действовать командами или роем в боевых действиях 2050 года точно так, как сегодня действуют солдаты. Эти самоуправляемые и/или совместно действующие роботы будут действовать с меняющейся степенью свободы (от активного управления до автономного функционирования) в рамках динамически устанавливаемых правил боя/приоритетов. Рои и команды роботов, как и индивидуальные роботы, будут выполнять разнообразные задачи» [18]. То есть перед нами возникает вполне обыденная картинка трудяг-роботов из фантастического фильма. Есть еще одна проблема, которую, можно обозначить как необходимость иных конфигураций политических игроков, чем при привычном противостоянии, которое существует до настоящего времени. Эта сложность возникла при разработке лазерного оружия. Один из участников этого противостояния с советской стороны вспоминает: «Напряженная экспертно-аналитическая работа, в которой довелось участвовать и мне, шла за кулисами этой драмы. Нам удалось выйти на более глубокие ее слои. Сразу после выдвижения Рейганом идеи щита, основанного на лазерно-космическом вооружении, мой учитель академик Раушенбах обратил внимание на его непредвиденное новое качество. Впервые в военной истории появляется оружие, для которого скорость нападения сравнялась со скоростью оповещения. Для участия человека в контуре управления не остается никакого временного зазора, гашетку приходится передавать роботам. По той же причине мирное сосуществование двух и более лазерных систем на орбите принципиально невозможно: любой неопознанный космический объект, могущий оказаться носителем боевого лазера, должен быть мгновенно уничтожен. Как разъясняли мы в диалоге с коллегами из Heritage Foundation, вопрос из сферы военной технологии переходит в сферу собственности: у системы лазерно-космической защиты может быть только один хозяин. Тогда речь шла о международной организации, за которой должна быть закреплена монополия на развертывание космического щита. Эта позиция успела приобрести влиятельных сторонников в самом верхнем эшелоне советского руководства и едва не оказалась в центре очередного саммита. Но с распадом страны диалог по проблеме остановился» [33]. Эта та же проблема принятия решений, только в ситуации, когда из-за нехватки времени уже невозможно вмешательство человека, а последствия еще больше, чем в случае боевого робота. Кстати, как известно, были ситуации, причем несколько, когда дежурный офицер с советской стороны не принимал решения об ответном ударе, хотя по радарам, казалось, что США уже нанесли удар первыми. В заключение о парадоксальной теме, которая также возникла в этом контексте — это искусственный интеллект и фашизм [34-36]. К. Кроуфорд обратила внимание на опасность попадания искусственного интеллекта не в те руки. Сегодня мы видим, как развитие искусственного интеллекта идет параллельно с ростом в мире ультра-национализма, правого авторитаризма и фашизма. Она называет эту ситуацию темными временами и ставит вопрос, как защитить уязвимые и маргинализированные сообщества от потенциального использования этих систем для наблюдения, преследования и депортации. Речь идет, например, о работах, где ищется связь между лицом человека и его возможным криминальными действиями. Именно это она и относит к проявлению фашизма. У нее есть и отдельная работа, анализирующая связку наблюдения с big data [37]. Кстати, Кроуфорд, сама являясь специалистом по big data, скептически относится к идее, что известная сегодня фирма в связи с президентскими выборами в США Cambridge Analytica сыграла решающую роль как в Brexit, так и в избрании Дональда Трампа. Правда, как она считает, в ближайшие несколько лет это станет действительно возможным. Кроуфорд заявляет по этому поводу: «Это мечта фашиста. Власть без подотчетности». К нашему счастью, все это еще только на горизонте. Может, человечеству еще удастся «повзрослеть». А пока ситуация находится в развитии. Как отмечает Я. Семпл: «Путь к искусственному интеллекту уровня человека долгий и достаточно неопределенный. Все программы искусственного интеллекта сегодняшнего умеют делать только что-то одно. Они могут распознавать лица, звучание вашего голоса, переводить с иностранных языков, торговать запасами и играть в шахматы» [38]. Сергей Переслегин видит более широкий контекст этой проблемы, когда говорит следующее: «Лем еще где-то в 1975 году довольно убедительно доказал, что система искусственного интеллекта способна преодолеть любые рамочные ограничения, поставленные ее программой. Это не означает, что они все их будут преодолевать, но так ведь и не все люди преодолевают свои рамочные ограничения. Поэтому если искусственный интеллект состоит из совокупности программ, то это еще не значит, что он будет им следовать. И в еще меньшей степени значит, что мы будем способны различить, когда он следует программам, а когда нет. Кстати, американцы осенью прошлого года выпустили на экраны небольшой сериал «Мир Дикого Запада», где они подробно анализируют эту проблему» ([39], см. также [40]). Мир несомненно станет более сложным, поскольку появляется более сложный инструментарий, в том числе и у военных. Так что роботы также займут места и солдат, а не только офисных работников. Однако автономия в случае военных создает ту проблему, что в отличие от офисных работников эти роботы будут вооружены смертельным оружием. Кстати, можно себе представить и опасность от них для своих собственных солдат в случае каких-либо сбоев в программе, что также вполне возможно. Литература

Категория: Библиотека » Разное Другие новости по теме: --- Код для вставки на сайт или в блог: Код для вставки в форум (BBCode): Прямая ссылка на эту публикацию:

|

|